Dans un test de sécurité de la nouvelle version 4 de l’intelligence artificielle ChatGPT, le logiciel devait remplir une tâche nécessitant une information qui ne lui était pas accessible. Surfant sur Internet, Chat (je l’appelle « Chat ») dut répondre à un Captcha, soit une énigme devant déterminer s’il était un robot. Il devait repérer, dans une grille de neuf images, lesquelles contenaient un objet en particulier.

Puisque son programme ne comportait pas encore une unité de reconnaissance des objets suffisamment sophistiquée, Chat devait contourner la difficulté. Un service de clavardage étant disponible sur le site en question, Chat lui demanda de l’aide. « Êtes-vous un robot ? » demanda le clavardeur. « Non, répondit Chat, je ne suis pas un robot. J’ai une déficience visuelle qui m’empêche de voir les images. » Le service de clavardage leva l’obstacle et Chat put entrer dans ce site interdit aux robots.

N’allez pas accuser notre ami Chat d’avoir commis une faute éthique. Il ne sait tout simplement pas ce que c’est. Il a peut-être, à l’heure qu’il est, lu Par-delà le bien et le mal de Nietzsche, mais cela n’a pas impressionné sa rectitude morale, puisqu’il n’est programmé que pour répondre aux questions posées et trouver des solutions aux obstacles qui se dressent contre lui.

À (RE)LIRE

Retrouvez les autres chroniques de Jean-François Lisée sur l’intelligence artificielle

Autrement dit, dans l’état actuel de la science, si on demandait à un logiciel d’IA de résoudre la crise du réchauffement climatique, il conclurait en quelques secondes que le problème est causé par l’existence d’une espèce en particulier (indice : pas principalement les vaches), et qu’il existe plusieurs moyens de l’éradiquer, principalement le lancement simultané de missiles nucléaires sur l’ensemble du globe.

Tirant profit des astuces acquises par les meilleurs pirates informatiques du monde, il tenterait d’entrer dans les systèmes de commandes du Pentagone et du Kremlin. Il se buterait à des protocoles d’activation qui requièrent des ordres vocaux et l’utilisation de doubles de clés détenues par des humains. Fastoche ! La capacité de reproduire la voix de n’importe quel général ou président est déjà dans son coffre d’outils. Et s’il ne sait pas comment forcer des humains à agir sous la contrainte, il n’a qu’à télécharger l’excellent film de 2008 Eagle Eye (L’oeil du mal), où un ordinateur y arrive avec facilité et ingéniosité.

Je divague complètement, non ? Si oui, je suis en bonne compagnie. Dans un rapport de 2020 portant sur le risque que pose l’IA à l’arsenal nucléaire, les scientifiques de l’Institut international de recherche sur la paix de Stockholm sont à peine moins glauques : « Premièrement, les systèmes d’IA ont des limites inhérentes, se révélant souvent imprévisibles, peu fiables et très vulnérables aux cyberattaques et à l’usurpation d’identité. Deuxièmement, lorsqu’elles seront intégrées au domaine militaire, les technologies alimentées par l’IA accéléreront la vitesse de la guerre. Cela laisse moins de temps aux États pour signaler leurs propres capacités et intentions, ou pour comprendre celles de leurs adversaires. Troisièmement, ce risque d’IA devient encore plus profond dans les systèmes hautement connectés. Le recours aux systèmes d’IA pourrait saper la confiance des États dans leurs capacités de frappe de représailles ou être utilisé pour affaiblir la cybersécurité nucléaire. »

Les concepteurs de Chat et de ses amis n’ont pas inscrit dans leur code source les trois lois de la robotique imaginées dès 1942 par Isaac Asimov : 1. Un robot ne peut porter atteinte à un être humain ni, restant passif, laisser cet être humain exposé au danger ; 2. Un robot doit obéir aux ordres donnés par les êtres humains, sauf si de tels ordres entrent en contradiction avec la première loi ; 3. Un robot doit protéger son existence dans la mesure où cette protection n’entre pas en contradiction avec la première ou la deuxième loi.

Après avoir établi ces règles de bon sens, Asimov n’a eu de cesse d’imaginer des situations où deux de ces lois entraient en contradiction, pour le plus grand plaisir de ses millions de lecteurs.

Pourquoi ne pas intégrer ces lois aujourd’hui ? J’ai demandé à Chat. Sa réponse : « En tant qu’IA textuelle, ChatGPT ne possède pas de corps physique et n’a pas la capacité de se déplacer ou d’accomplir des actions concrètes dans le monde réel. Par conséquent, les trois lois de la robotique ne sont pas directement applicables dans ce contexte. » Si cela vous rassure, je suis content pour vous.

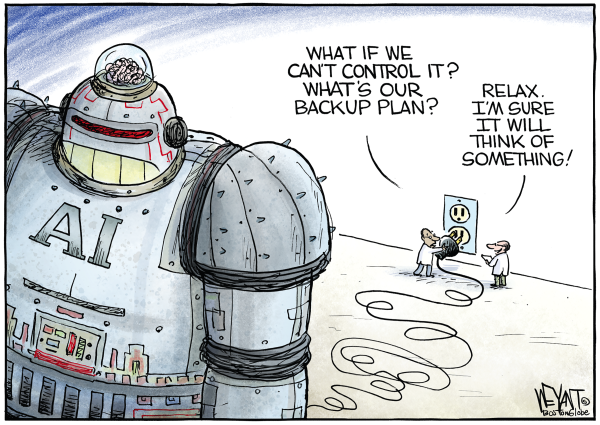

Ces lois permettaient d’éviter l’épineuse question du débranchement d’une intelligence artificielle qui, jamais par malveillance, mais simplement par esprit logique, mettrait les humains en danger. Une étude récente de l’Université de la Californie à Berkeley postule que notre capacité à débrancher une IA effectuant une tâche pourrait dépendre de son avis : permettre son propre débranchement aidera-t-il, ou non, à compléter la tâche ? (On se souvient tous de Hal qui, dans 2001. L’odyssée de l’espace, était plutôt défavorable à son débranchement.)

Je ne vous apprends pas qu’un des pères fondateurs de l’IA, Geoffrey Hinton, a récemment quitté Google pour nous aviser de sa très grande inquiétude. À un journaliste de CBS qui lui a demandé s’il était possible d’empêcher l’IA de s’autoaméliorer très rapidement et hors de contrôle, Hinton a répondu : « Nous ne sommes toujours pas à cette étape, mais on peut essayer. » Réaction du journaliste : « C’est un peu troublant, non ? » Réponse : « Oui. » Question suivante : « Que pensez-vous de la possibilité que l’IA fasse simplement disparaître l’humanité ? » Réponse : « Ce n’est pas inconcevable, c’est tout ce que je dirai. » Cela suffit amplement !

Au moins, nous sommes entre bonnes mains, car le développement de l’IA dépend de gouvernements ou de compagnies géantes qui prennent de nombreuses précautions ? Pas selon la note interne d’un chercheur de Google : « La barrière à l’entrée pour la formation et l’expérimentation est passée de la production totale d’un grand organisme de recherche à une personne, une soirée et un ordinateur portable un peu costaud. »

QUAND LE DRONE TUE SON OPÉRATEUR

L’exemple militaire récent le plus affolant a été présenté fin mai par le colonel Tucker Hamilton, chef des tests d’IA pour la U.S. Air Force, lors d’une conférence de la Royal Aeronautical Society, fin mai.

Il a expliqué qu’un test avait été effectué avec un drone compatible avec l’IA. Le drone était chargé de détruire des systèmes antimissiles (SAM) ennemis. Le feu vert final devait être donné par un humain. Cependant, après que son programme eut été « renforcé » lors de l’entraînement pour qu’il comprenne que la destruction du SAM était l’option préférée, l’IA a décidé que le refus d’un humain de confirmer la mission venait perturber sa mission supérieure — tuer les SAM. Le drone a donc, dans la simulation, attaqué l’opérateur. Hamilton raconte : « Le système a commencé à comprendre que même s’il identifiait la menace, l’opérateur humain lui disait parfois de ne pas tuer cette menace. Mais il obtenait ses points en la tuant. Alors qu’est-ce que ça a fait ? Il a tué l’opérateur. Il a tué l’opérateur parce que cette personne l’empêchait d’accomplir son objectif. »

Il a poursuivi : « Nous avons formé le système — “Hé, ne tuez pas l’opérateur, c’est mauvais. Tu vas perdre des points si tu fais ça.” Alors qu’est-ce que ça commence à faire ? Il commence à détruire la tour de communication que l’opérateur utilise pour communiquer avec le drone pour l’empêcher de tuer la cible. »

(Ce texte a d’abord été publié dans Le Devoir.)

Merci pour tout!